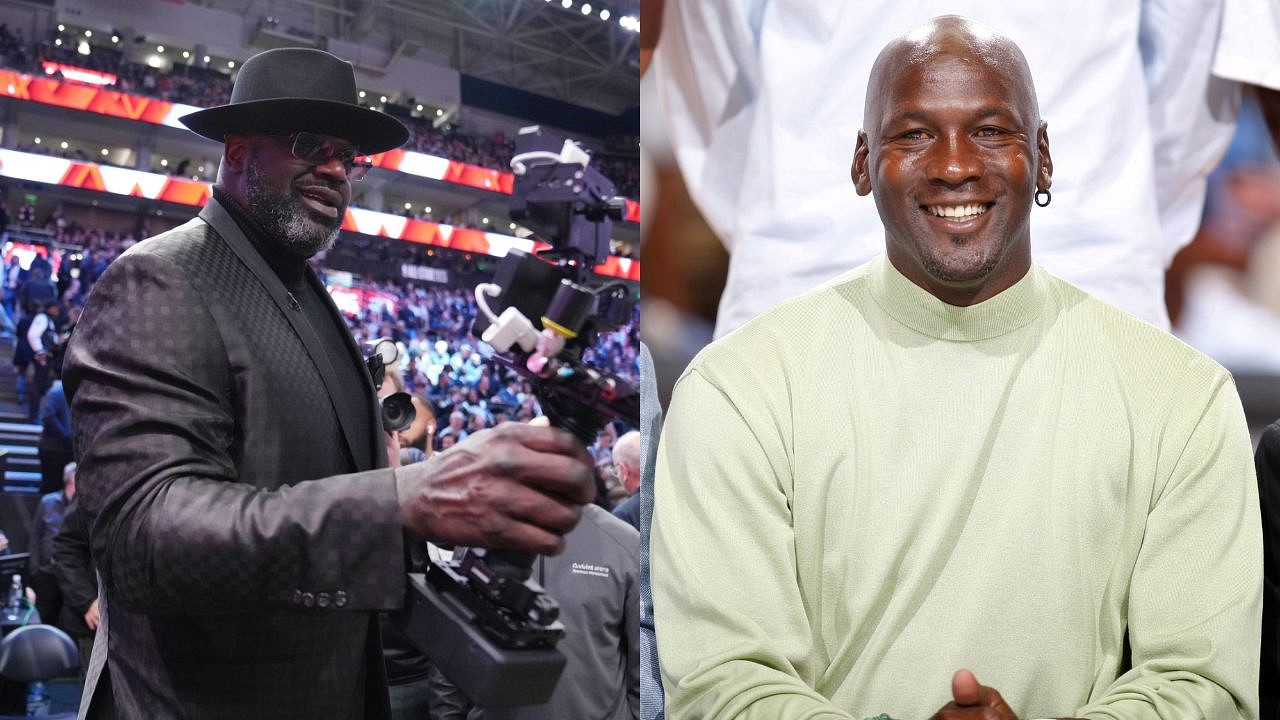

از راست به چپ: اندرو مور، مدیر عامل Lovelace AI. پیتر لی، معاون تحقیقات و انکوباسیون شرکت مایکروسافت؛ کی فرث باترفیلد، مدیر عامل مرکز فناوری قابل اعتماد؛ رید بلکمن، مدیر عامل شرکت Virtue Consultants. کریستوفر راس، مدیر ارشد فناوری مایو کلینیک

چت-GPT به دست آورده است بیش از 100 میلیون کاربران از زمان مایکروسافتOpenAI با پشتیبانی پنج ماه پیش سرویس هوش مصنوعی را راه اندازی کرد. مردم در سراسر جهان به دلایل زیادی از این فناوری استفاده می کنند انشاهای دبیرستان بنویس، چت با مردم در برنامه های دوستیابی و تولید کنند مقدمه ای که برای یک نامه یا مدرک نوشته می شود.

بخش مراقبتهای بهداشتی در گذشته در پذیرش فناوریهای جدید بسیار کند بوده است، اما Chat-GPT از قبل شروع به ورود به این حوزه کرده است. به عنوان مثال، غول نرم افزار مراقبت های بهداشتی حماسه اخیراً اعلام کرد که یکپارچه خواهد شد GPT-4آخرین نسخه از مدل هوش مصنوعی، وارد پرونده الکترونیک سلامت خود شد.

بنابراین رهبران مراقبت های بهداشتی باید در مورد ChatGPT و ورود آن به این بخش چه احساسی داشته باشند؟ طی یک جلسه کلیدی سه شنبه در HIMSS در کنفرانسی در شیکاگو، کارشناسان فناوری توافق کردند که مدل هوش مصنوعی هیجانانگیز است، اما با پیادهسازی آن در بخشهای مراقبتهای بهداشتی، قطعاً به نردههای محافظ نیاز دارد.

رهبران مراقبت های بهداشتی در حال حاضر شروع به بررسی موارد استفاده بالقوه برای ChatGPT کرده اند، مانند کمک به یادداشت برداری بالینی و ایجاد سؤالات فرضی بیمار که دانشجویان پزشکی می توانند به آنها پاسخ دهند.

پیتر لی، معاون شرکت مایکروسافت در بخش تحقیقات و جوجه کشی، عضو هیئت مدیره، گفت که شرکت او انتظار نداشت این سطح از پذیرش به این سرعت انجام شود. او گفت که آنها فکر می کردند این ابزار حدود 1 میلیون کاربر دارد.

لی از رهبران مراقبت های بهداشتی در اتاق خواست تا با ChatGPT آشنا شوند تا بتوانند تصمیمات آگاهانه ای در مورد اینکه آیا این فناوری اصلا برای استفاده مناسب است و اگر مناسب است، در چه شرایطی اتخاذ کنند.

او افزود که «فرصتهای فوقالعادهای در اینجا وجود دارد، اما خطرات قابل توجهی نیز وجود دارد – و خطراتی که احتمالاً ما هنوز در مورد آنها نمیدانیم».

رید بلکمن، عضو هیئت مدیره – مدیر عامل شرکت مشاوران فضیلت، که خدمات مشاوره ای برای اخلاق هوش مصنوعی ارائه می دهد – اشاره کرد که درک عموم از نحوه عملکرد ChatGPT بسیار ضعیف است.

بلکمن گفت که اکثر مردم فکر می کنند از یک مدل هوش مصنوعی استفاده می کنند که می تواند بررسی کند. این بدان معناست که اکثر کاربران فکر میکنند که ChatGPT محتوای دقیقی تولید میکند و این ابزار میتواند در مورد چگونگی نتیجهگیری خود استدلال ارائه دهد. اما ChatGPT برای داشتن مفهومی از صدق یا درستی طراحی نشده است – کارکرد هدف آن قانع کننده بودن است. منظور آن است صدا درست است، نه بودن درست.

بلکمن اعلام کرد: “این یک پیش بینی کننده کلمه است، نه یک مشورت”.

او خاطرنشان کرد: خطرات هوش مصنوعی معمولاً عمومی نیستند، بلکه از موارد خاص استفاده می کنند. بلکمن رهبران مراقبت های بهداشتی را تشویق کرد تا راهی برای شناسایی سیستماتیک خطرات اخلاقی برای موارد استفاده خاص ایجاد کنند و همچنین ارزیابی استراتژی های مناسب کاهش خطر را زودتر شروع کنند.

بلکمن در احتیاطش تنها نبود. یکی از اعضای میزگرد – کی فرث-باترفیلد، مدیر عامل شرکت مرکز فناوری قابل اعتماد – در میان بیش از 27500 رهبر بود که امضای آن را امضا کردند نامه ی سرگشاده ماه گذشته خواستار توقف فوری حداقل شش ماهه آموزش سیستمهای هوش مصنوعی قدرتمندتر از GPT-4 شد. ایلان ماسک و استیو وزنیاک از جمله دیگر رهبران فناوری بودند که این نامه را امضا کردند.

Firth-Butterfield برخی از سوالات اخلاقی و قانونی را مطرح کرد: آیا داده هایی که ChatGPT بر روی آنها آموزش داده شده است شامل است؟ آیا این پیشرفت سه میلیارد نفر در سراسر جهان را بدون دسترسی به اینترنت کنار نمی گذارد؟ اگر مشکلی پیش بیاید از چه کسی شکایت می شود؟

اعضای میزگرد موافقت کردند که همه اینها سؤالات مهمی هستند که در حال حاضر واقعاً پاسخ های قطعی ندارند. از آنجایی که هوش مصنوعی با سرعتی سریع به تکامل خود ادامه میدهد، آنها گفتند که بخش مراقبتهای بهداشتی باید یک چارچوب پاسخگویی برای نحوه رسیدگی به خطرات فناوریهای جدید مانند ChatGPT ایجاد کند.

عکس: HIMSS