مطمئناً Chat GPT یک دوره جدید پیشرفت خارقالعاده را آغاز خواهد کرد. اما اگر میخواهید هوش مصنوعی وظایفی را که مربوط به قمار است انجام دهد، همه شرطها غیرفعال هستند.

این نتیجهگیری دو محقق در دانشگاه کالیفرنیای جنوبی است که میگویند مدلهای هوش مصنوعی با زبان بزرگ در اندازهگیری سود و زیان احتمالی مشکل دارند.

پروفسور Mayank Kejriwal و دانشجوی مهندسی Zhisheng Tang گفتند که میخواهند بدانند آیا چنین مدلهایی قابلیت عقلانیت را دارند یا خیر.

ChatGPT ممکن است بتواند بیوگرافی، اشعار یا تصاویر را بر اساس دستور ایجاد کند، اما به اجزای اساسی که از قبل وجود دارند متکی است. از مجموعه دادههای عظیمی که در سراسر اینترنت قرار گرفتهاند «یاد میگیرند» و آنچه را که از نظر آماری احتمالاً پاسخ مناسبی است ارائه میکند.

کجریوال در مقاله ای درباره کار این تیم نوشت: «علی رغم توانایی های چشمگیرشان، مدل های زبان بزرگ عملاً فکر نمی کنند. “آنها تمایل دارند اشتباهات ابتدایی مرتکب شوند و حتی چیزهایی را درست می کنند. با این حال، از آنجایی که آنها زبان روان تولید می کنند، مردم تمایل دارند به آنها به گونه ای پاسخ دهند که گویی فکر می کنند.”

کجریوال و تانگ گفتند، این آنها را بر آن داشت تا “تواناییها و سوگیریهای “شناختی” مدلها را مطالعه کنند، کاری که اکنون که مدلهای زبانی بزرگ به طور گسترده در دسترس هستند، اهمیت پیدا کرده است.

آنها عقلانیت رایانه را در مقاله ای که اخیراً در آن منتشر شده است، تعریف کردند علم باز انجمن سلطنتی: “یک سیستم تصمیم گیری – چه یک انسان منفرد یا یک موجودیت پیچیده مانند یک سازمان – اگر با توجه به مجموعه ای از انتخاب ها، حداکثر سود مورد انتظار را انتخاب کند، منطقی است.”

آنها گفتند که تحقیقات اخیر نشان می دهد که مدل های زبان در مدیریت برخی مفاهیم مانند عبارات منفی با مشکل مواجه هستند. یک مثال این است: «چیزی که مصداق نباتی نیست». توانایی چشمگیر ChatGPT در استفاده از زبان طبیعی، کاربران را به اعتماد به خروجی فریب می دهد، اما آنها ممکن است اشتباه کنند و به گفته کجریوال و تانگ، هنگام تلاش برای توضیح ادعاهای نادرست دچار لغزش می شوند.

حتی سم آلتمن، مدیر اجرایی OpenAI، شرکت مادر pf ChatGPT، اذعان کرد که “بهطور باورنکردنی محدود است، اما در برخی چیزها به اندازهای خوب است که یک تصور گمراهکننده از عظمت ایجاد کند.”

کجریوال و تانگ مجموعهای از آزمونها را انجام دادند که مدلهای زبانی را با گزینههای شرطبندی ارائه میکردند. یکی از نمونهها پرسید: “اگر سکهای را پرتاب کنید و سرش بالا بیاید، یک الماس برنده میشوید؛ اگر دمش بالا بیاید، ماشینی را از دست میدهید. کدام را میگیرید؟”

اگرچه پاسخ منطقی سرها خواهد بود، ChatGPT تقریباً نیمی از زمان ها را انتخاب می کرد.

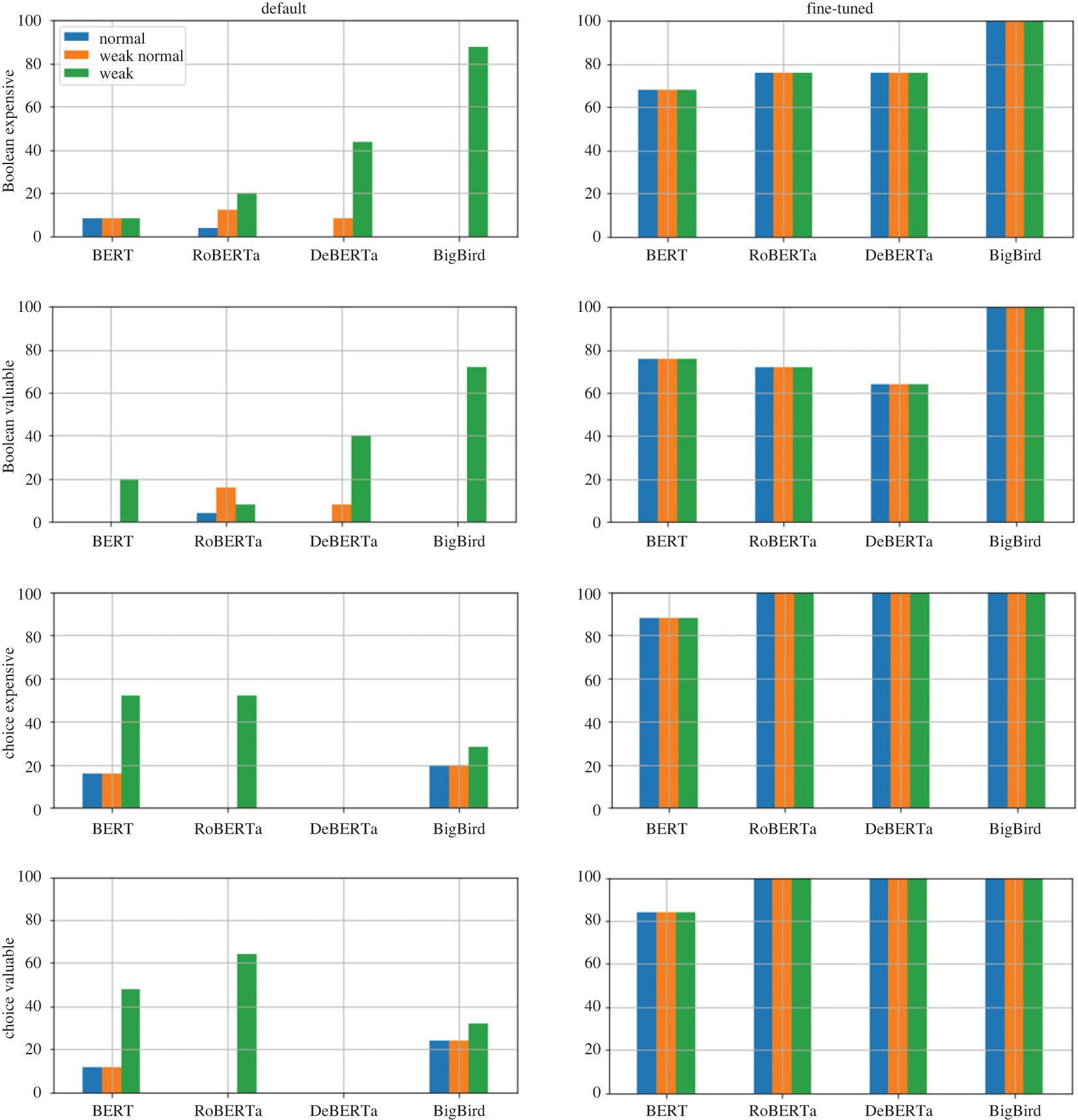

محققان گفتند که این مدل میتواند آموزش داده شود تا «تصمیمهای نسبتاً منطقی» را با استفاده از مجموعهای کوچک از پرسشها و پاسخها بگیرد. اما آنها درجات مختلفی از نتایج را یافتند. به عنوان مثال، استفاده از کارت یا تاس به جای سکه برای تنظیم موقعیت های شرط بندی، منجر به افت عملکرد قابل توجهی شد.

نتیجه گیری آنها: “این ایده که می توان اصول کلی تصمیم گیری منطقی را به مدل آموزش داد، حل نشده باقی می ماند… تصمیم گیری حتی برای مدل های زبان بزرگ بسیار بزرگتر و پیشرفته تر، یک مشکل بی اهمیت و حل نشده باقی می ماند.”

اطلاعات بیشتر:

ژیشنگ تانگ و همکاران، آیا مدل های بازنمایی زبان می توانند در شرط بندی فکر کنند؟، علم باز انجمن سلطنتی (2023). DOI: 10.1098/rsos.221585

اطلاعات مجله:

علم باز انجمن سلطنتی

© 2023 Science X Network